Que se passe-t-il lorsque l’on pose une question politiquement sensible à deux programmes d’intelligence artificielle occidentaux et au nouveau programme chinois DeepSeek ? Nous avons décidé de le découvrir, comme le rapporte Cathy Vogan.

Par Cathy Vogan – Le 1 février 2025 – Source Consortium News

La nouvelle qu’un programme d’IA chinois baptisé DeepSeek surpasse l’IA occidentale pour une fraction de son coût de développement a fait les gros titres dans le monde entier, notamment parce qu’elle a fait chuter les actions des entreprises occidentales spécialisées dans l’IA.

La nouvelle qu’un programme d’IA chinois baptisé DeepSeek surpasse l’IA occidentale pour une fraction de son coût de développement a fait les gros titres dans le monde entier, notamment parce qu’elle a fait chuter les actions des entreprises occidentales spécialisées dans l’IA.

« Les douves que les États-Unis ont construites pour protéger leurs entreprises de la concurrence nationale ont en fait créé les conditions qui les ont atrophiés. Elles étaient devenues grasses et heureuses à l’intérieur de leurs châteaux », écrit Drop Site News. « Leur activité est passée de l’innovation technologique à l’alchimie des feuilles de calcul, transformant des mesures inventées en valorisations en dollars détachées de la réalité ».

« Aujourd’hui, DeepSeek a révélé cette escroquerie. Avec une infime partie des ressources et sans accès à la panoplie complète de la technologie des puces américaines, la société chinoise DeepSeek a mis une déculottée à la Silicon Valley ».

Continuer la lecture →

Par

Par

La nouvelle qu’un programme d’IA chinois baptisé DeepSeek surpasse l’IA occidentale pour une fraction de son coût de développement a fait les gros titres dans le monde entier, notamment parce qu’elle a fait chuter les actions des entreprises occidentales spécialisées dans l’IA.

La nouvelle qu’un programme d’IA chinois baptisé DeepSeek surpasse l’IA occidentale pour une fraction de son coût de développement a fait les gros titres dans le monde entier, notamment parce qu’elle a fait chuter les actions des entreprises occidentales spécialisées dans l’IA.

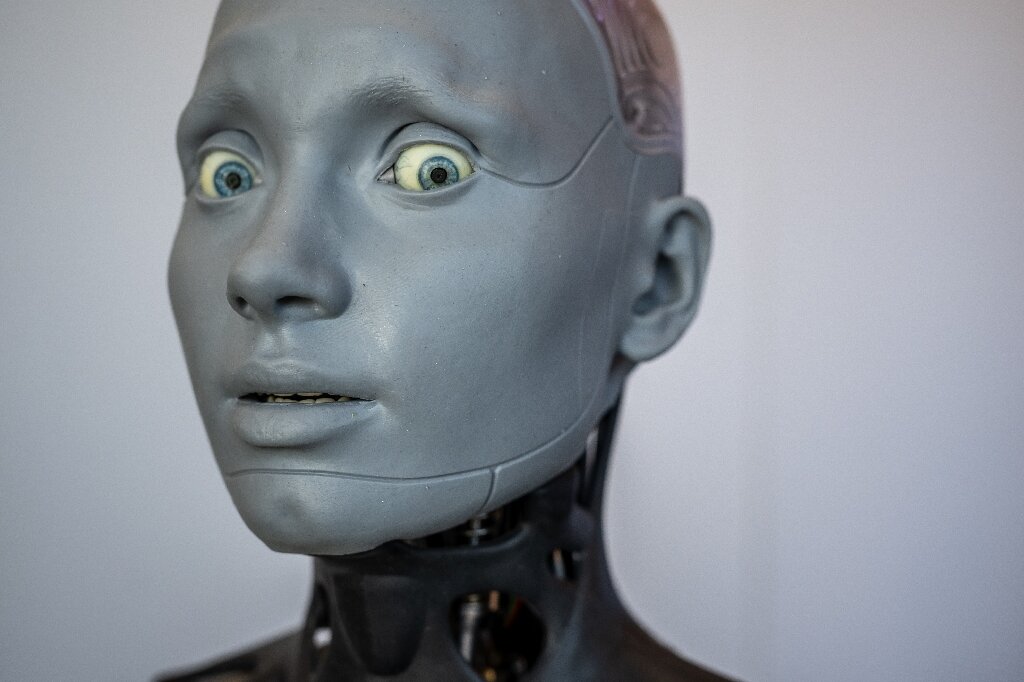

Le premier robot humanoïde électrique au monde, le « Tiangong » a été mis en mode open source lundi, une initiative qui devrait faciliter le développement secondaire des robots humanoïdes et accélérer l’intégration des robots dans la vie humaine.

Le premier robot humanoïde électrique au monde, le « Tiangong » a été mis en mode open source lundi, une initiative qui devrait faciliter le développement secondaire des robots humanoïdes et accélérer l’intégration des robots dans la vie humaine.