Par Simplicius Le Penseur – Le 17 janvier 2024 – Source Dark Futura

L’IA est de plus en plus utilisée pour nous guider dans la boucle du complexe industriel de consommation afin de maximiser les profits des sociétés mères. Les entreprises investissent des milliards dans la collecte de chaque cellule numérique de données afin de suivre nos moindres mouvements, pensées et inclinations avec une manipulation aussi fine que possible. Ces « cookies » numériques sont devenus de plus en plus complexes pour former des profils entiers de nous : nos moindres penchants, nos horaires et nos biorythmes.

Tout cela se fait avec une sophistication croissante dans laquelle l’intelligence artificielle joue un rôle central. Les traqueurs peuvent suivre chacun de vos mouvements afin d’élaborer une évaluation plus « intelligente », s’inspirant des profils psychologiques, sur la base de vos habitudes. Et le type de données qu’ils peuvent synthétiser en mesures utilisables devient de plus en plus surprenant, suivant nos dérives nomades dans le paysage numérique simplement en faisant correspondre les métadonnées de marqueurs décalés comme le pourcentage de batterie de notre téléphone, ou d’autres identifiants uniques qui, à première vue, ne semblent pas rompre l’anonymat de l’utilisateur. L’IA rassemble les marqueurs de données disparates en un profil prédictif de nos habitudes, dont la précision augmente à chaque itération, nous submergeant du fléau consumériste des « opportunités » ciblées.

Au fur et à mesure que les IA deviennent progressivement autonomes et se transforment en assistants, agents et majordomes numériques, elles commenceront à jouer un rôle dans notre processus de prise de décision sur le marché de la consommation numérique. Si l’on pousse l’idée assez loin, à un moment donné, nous nous retrouverons essentiellement avec des robots qui achèteront et vendront : une sorte d’économie de simulacre dans laquelle nous pourrions être progressivement mis à l’écart. En fin de compte, nos « digi-nounous » pourraient de facto prendre en charge nos décisions domestiques, allant jusqu’à la suggestion, voire à la gestion carrément autonome de nos tâches quotidiennes.

La prochaine phase de l’innovation en matière d’IA réside précisément dans ce point, et c’est ce qui occupe actuellement la plupart des experts dans ce domaine : l’avènement d’un « agent » IA à plein temps en tant qu’assistant personnel qui s’occupera non seulement des tâches subalternes et triviales, mais aussi des dépenses monétaires.

Voici, à titre d’exemple, une nouvelle intervention lors d’un récent symposium :

Ce que nous voulons, c’est arriver à un point où nous pourrons confier notre argent à ces agents, afin qu’ils puissent faire des choses en notre nom. Les LLMs comme des « enfants avec vos cartes de crédit ».

Le présentateur affirme que le développement de ces agents constitue la prochaine grande frontière du secteur et qu’il se fera en deux étapes. La première est l’évolution naturelle du modèle SIRI, où l’agent commencera à « agir » selon nos instructions, plutôt que de se contenter de récupérer des informations, de sauvegarder des notes et des listes de courses, etc. Mais l’étape évolutive suivante verra ces agents passer de simples « majordomes » serviles à ce que le présentateur appelle une « IA holistique ».

Il s’agira d’agents qui ne se contenteront pas d’exécuter nos instructions, mais participeront activement au processus de prise de décision, soit en nous présentant des choix différents de ceux que nous aurions envisagés, soit en comprenant simplement de manière « holistique » les besoins qui sous-tendent notre demande, de manière à modifier éventuellement la recherche d’informations ou l’exécution de la tâche de manière à ce qu’elle nous convienne mieux que nous n’aurions su le faire nous-mêmes. Pour cela, l’IA devra nous connaître mieux que nous ne nous connaissons nous-mêmes.

L’exemple cité est le suivant : si nous demandons à l’agent de nous réserver des billets d’avion pour Los Angeles, l’« IA holistique » peut d’abord nous demander pourquoi nous voulons aller là-bas, et à ce moment précis. En fonction de notre réponse, elle peut nous proposer des modifications nouvelles, inédites ou intéressantes, voire des alternatives. Par exemple, vous pouvez répondre « Je voulais assister au festival de jazz de Los Angeles ». L’IA sera alors en mesure de vous recommander un festival encore meilleur ailleurs, dont vous ignoriez l’existence.

Le problème – que le présentateur souligne – est que ces agents devront nous connaître… intimement pour être efficaces, ce qui signifie qu’ils auront besoin d’un accès total à nos vies et à toutes nos données. Il en va de même pour l’exécution des tâches : vous ne pouvez pas attendre d’un agent qu’il tienne vos comptes avec compétence s’il n’a pas un accès total à ces comptes et services personnels, comme vos portails bancaires, etc. Et étant donné que ces IA seront presque conscientes, ou du moins autonomes à des degrés élevés, c’est comme si une personne dont la fiabilité ou l’intégrité est douteuse avait accès à vos informations les plus cruciales.

Bien sûr, les technophiles proposent diverses idées pour intégrer des mesures de sécurité dans les systèmes, mais il s’agit néanmoins de la principale préoccupation naturelle de chacun. À titre d’exemples récents, il y a eu au moins deux cas de modèles de langage d’IA qui ont été au moins déclarés comme s’étant détraqués ou malhonnêtes, et qui ont fait « fuir » des fichiers personnels d’utilisateurs confidentiels.

Je me trouve dans la position légèrement inconfortable d’être prédisposé avec une tendance techno-sceptique, et de n’avoir jamais confié ma « sécurité » aux divers mécanismes de vérification de la nouvelle ère, qu’il s’agisse de la paume de la main, des empreintes digitales ou des scans de l’iris, tout en restant prudemment fasciné par les développements technologiques en cours. Je considère l’IA comme une étape naturelle et irrépressible de l’évolution humaine, à laquelle il est inutile de résister, car elle se produira, que nous le voulions ou non. Cependant, je reste convaincu que ces développements devraient être rendus aussi facultatifs que possible pour la société dans son ensemble, et que tout le monde devrait conserver une méfiance et un scepticisme sains à l’égard de ces systèmes, surtout si l’on connaît le type de personnalités aux tendances sombres qui animent la scène des start-ups technologiques.

La semaine dernière a vu la première annonce majeure dans le domaine de ces nouveaux agents : le dispositif Rabbit R1. Il est conçu précisément autour du concept « push over pull« , prétendant révolutionner les LLM (Large Language Models) dans leur mode propriétaire de LAM : Large Action Model.

L’objectif de l’appareil s’apparente à un « SIRI » portable, mais qui peut en fait accomplir avec compétence de nouvelles tâches pour vous, comme réserver des billets d’avion, remplir des formulaires en ligne qu’il n’a jamais vus auparavant, etc. plutôt que de se contenter de récupérer des informations.

Voir ci-dessous : (Voir la vidéo sur l’article original)

Si l’on pousse cette idée assez loin, on peut imaginer le lent glissement sur la pente glissante de notre agent virtuose de l’IA devenant, en fait, un fac-similé de… nous. Vous êtes peut-être sceptique, mais il y a de nombreuses façons dont cela peut se produire dans la pratique. Cela commencerait par de petites commodités, comme la prise en charge par l’IA de ces tâches quotidiennes ennuyeuses – les encombrements quotidiens tels que la commande de nourriture, la réservation de billets, la gestion d’autres obligations financières et administratives. L’acceptation se ferait lentement, bien sûr. Mais une fois le stade de la « nouvelle normalité » atteint, nous pourrions nous trouver à un pas d’une perte d’humanité très troublante en raison de l’accumulation de ces « allocations de commodité ».

Que se passera-t-il lorsqu’une IA fonctionnant comme un « nous » de substitution commencera à jouer un rôle plus important dans l’exécution des fonctions de base de notre vie quotidienne ? Rappelons que les humains ne remplissent qu’une « fonction » essentielle dans la société corporatocratique d’aujourd’hui, en raison de notre rôle de pourvoyeurs de liquidités et de garants de cette « vitesse » financière si importante. Nous faisons tourbillonner l’argent pour les entreprises, en veillant à ce que leur système impénétrablement complexe soit graissé et en générant toujours un sommet mousseux que les techno-financiers-koulaks peuvent « écrémer » comme du babeurre. Nous achetons des choses, puis nous gagnons de l’argent, et nous le dépensons pour d’autres choses – en maintenant l’ensemble du processus « dans le réseau » d’un cartel de plus en plus petit qui fait des profits sur les fluctuations volatiles, les jeux empoisonnés de recherche de rente, les processus occultes de seigneuriage et d’arbitrage. Contrôlant le secteur de la publicité numérique, Google nous fait passer par une hyper boucle composée d’une petite poignée d’autres mégacorporations pour boucler le cycle de l’argent partant en vrille.

Nos « assistants numériques » peuvent progressivement automatiser nos vies de telle sorte que les publicités puissent un jour les cibler plutôt que nous. Il peut s’agir d’une forme différente de publicité, bien sûr : nous ne pouvons pas assumer le même moule « psychologique » pour nos substituts. Mais cela nous amène à la partie critique de l’expérience de pensée : que se passera-t-il lorsque les machines commenceront à s’insérer directement entre nous et le système, prenant notre place en tant qu’intermédiaires à part entière dans la boucle de consommation ?

Exemple : un agent peut écrire des articles, ce qu’il sait déjà faire à moitié. Lorsque ces articles commencent à vous rapporter de l’argent de manière de plus en plus autonome, l’agent peut, par commodité, être invité à dépenser cet argent en votre nom, pour acheter des produits de première nécessité ou même des articles de loisir. Lorsqu’il devra choisir pour ces achats – entre des articles de prix similaires, par exemple – l’agent devra s’appuyer sur des publicités – on peut le supposer – tout comme nous le faisons, pour différencier les produits et prendre une décision sur le meilleur.

À quel moment d’une telle progression l’agent devient-il effectivement un substitut de « nous » et nous sort-il entièrement de la boucle consumériste ? Dans quel but une entreprise ciblerait-elle ses publicités sur nous plutôt que directement sur nos agents, qui prennent les principales décisions en notre nom afin de nous libérer des mondanités qui prennent du temps ? Et si un tel moment arrive, où en sommes-nous en tant qu’humains, à quoi servons-nous encore ? Ne nous restera-t-il plus qu’à « quitter la scène » en silence ?

En guise de tangente : quelles seraient les ramifications juridiques d’une telle situation ? Une IA générant des revenus de manière autonome serait techniquement considérée comme un contribuable, ce qui nécessiterait un numéro d’identification de l’employé (EIN), sans parler du seuil des discussions sur la « personnalité » et son extension naturelle : les droits individuels, entre autres choses. En outre, quelles seraient les implications juridiques en matière de responsabilité ? L’IA peut-elle être poursuivie pour des résultats frauduleux ou nuisibles ? Qui doit être tenu responsable de ses erreurs ? Dans une certaine mesure, nous sommes déjà confrontés à ce problème lorsqu’il s’agit de voitures auto-conduites et des responsabilités juridiques floues qui en découlent.

La situation deviendra encore plus floue lorsque nous atteindrons un tel niveau d’autonomie des agents qu’ils pourront commencer à reproduire totalement nos personnalités et nos présentations corporelles, de sorte qu’ils pourront agir comme des « substituts » de nous. Cela pourrait être utilisé lors de transactions ou d’interactions, qu’elles soient professionnelles, personnelles ou récréatives. Par exemple : dans un monde de plus en plus enrichi par la RV/AR, l’IA pourrait prendre nos visages, qui pourraient être superposés à n’importe quel corps androïde ou à n’importe quel avatar numérique.

Voici l’amusement de Russe Dmitry Peskov lorsqu’il a été transformé en Elon Musk par Deepfake en temps réel lors de la foire technologique russe du mois dernier :

(Voir la vidéo sur l’article original)

Vous pouvez facilement imaginer les utilisations incroyables qui peuvent en être faites.

Les « deepfakes« en général sont de plus en plus convaincants, notamment en ce qui concerne leur capacité à synthétiser et à reproduire des voix. Deux exemples récents de la nouvelle technologie de doublage de la bouche et de reproduction de la voix :

(Voir la vidéo sur l’article original)

Arriverons-nous à des identités « empruntées » et temporaires ? Si l’IA peut se faire passer pour nous à un degré d’imperceptibilité de 99,9 %, qu’est-ce qui l’empêcherait d’être employée en tant que « nous », au moins dans une certaine mesure, et peut-être même de « partager » l’identité à sa guise ? L’avenir sera-t-il marqué par une sorte de cohabitation des identités, lorsque les humains choisiront de fusionner avec leurs « agents » IA pour devenir des variantes véritablement transhumanistes de l’Homme 2.0 ? Sans parler des IA malhonnêtes qui se font passer pour nous sans raison, à des fins hostiles et sournoises.

Lors du conclave 2023 du WEF à Davos, ils ont imaginé comment, dans un avenir proche, nos « ondes cérébrales » seront synchronisées vers nos employeurs, ce qui leur permettra de surveiller nos performances mentales et notre vivacité d’esprit :

La vidéo complète poursuit en disant que « ce que nous pensons et ressentons ne sont que des données […] qui peuvent être décodées par l’intelligence artificielle ».

Il est clair que nos planificateurs centraux ont l’intention de nous connecter à des IA qui lisent le cerveau et qui pourraient finir par fonctionner de certaines des manières décrites dans l’introduction. Au début, cela peut prendre des formes « inoffensives », comme la surveillance de l’activité. Mais à terme, les mécanismes passeront invariablement de la passivité à l’activité, en poussant, en interférant ou en supplantant carrément nos propres activités cérébrales. Si vous pensez qu’il s’agit là du domaine de la science-fiction, les dernières mises à jour nous ont déjà apporté une IA capable de décoder les pensées de manière non intrusive, à l’aide d’une simple casquette portée sur la tête :

Pour l’instant, la précision annoncée n’est que de 40 %, mais elle devrait s’améliorer avec le temps. Combien de temps faudra-t-il attendre avant qu’elle puisse passer de la récupération à une version active, en implantant des pensées et des « impulsions » coercitives pour des actions subliminales ? Et dans combien de temps l’IA jouera-t-elle le rôle de « chef de chœur » à l’intérieur de notre crâne ?

Jimmy Dore vient de consacrer un épisode entier à l’annonce de Mark Zuckerberg selon laquelle, à l’avenir, « Facebook sera alimenté par des pensées télépathiques » – une idée si effrayante qu’il faut la voir pour la croire.

À l’avenir, les utilisateurs de Facebook partageront entre eux des pensées et des sentiments télépathiques. Vous pourrez simplement capturer une pensée, ce que vous pensez ou ressentez dans une sorte de forme idéale et parfaite dans votre tête, et la partager avec le monde dans un format qu’ils pourront décoder.

Mais voici le clou du spectacle :

Il a appelé les gens à penser moins en termes de nations qu’en tant que « citoyens d’une communauté mondiale », en mettant les innovations technologiques au service du progrès.

Woah, là.

Cette idée est en parfaite adéquation avec le fameux diktat du WEF de Klaus Schwab selon lequel l’avenir n’aura « pas besoin d’élections, parce que nous saurons déjà comment chacun votera » – par le biais de la même idée d’« implant cérébral ».

(Voir la vidéo sur l’article original)

La direction que prend le cartel technologique avec ces technologies devient douloureusement claire. Cela fait partie intégrante du plan Coudenhove-Kalergi, antérieur à l’Union européenne, qui dessinait l’avenir de l’humanité sous l’égide d’un gouvernement mondial centralisé.

Un danger évident est que les nouveaux développements de l’IA peuvent nous aider à atteindre cet objectif d’une manière étonnamment variée : soit en contrôlant ou en surveillant nos pensées comme indiqué ci-dessus, soit en nous rendant tout simplement obsolètes en prenant tous nos emplois, laissant les humains biologiques privés de leurs droits et dépendants des subventions du tout-puissant gouvernement pour le revenu universel.

Cet article classique de WIRED datant du début du siècle, en avril 2000, a bien saisi l’air du temps en pronostiquant l’avenir qui attendait l’humanité avec l’avènement de l’IA :

D’un autre côté, il est possible que l’homme conserve le contrôle des machines. Dans ce cas, l’homme moyen pourra contrôler certaines machines privées, comme sa voiture ou son ordinateur personnel, mais le contrôle des grands systèmes de machines sera entre les mains d’une petite élite – comme aujourd’hui, à deux différences près.

Et encore une fois, le clou du spectacle :

mais avec deux différences. En raison de l’amélioration des techniques, l’élite aura un plus grand contrôle sur les masses ; et parce que le travail humain ne sera plus nécessaire, les masses seront superflues, un fardeau inutile pour le système. Si l’élite est impitoyable, elle peut tout simplement décider d’exterminer la masse de l’humanité.

L’un des principaux problèmes de notre époque est que l’IA est de plus en plus vendue comme un élixir pour résoudre les problèmes sociétaux fondamentaux. Or, ces problèmes ne sont pas abordés ou résolus de quelque manière que ce soit, mais plutôt « dissimulés » sous des artifices technologiques.

Par exemple, les promoteurs de ces technologies vantent souvent les mérites des « assistants numériques », qui peuvent apporter aide et réconfort aux personnes seules et âgées, aux personnes qui dépérissent dans la solitude confinée des maisons de retraite stériles, et qui n’ont ni famille ni amis pour s’occuper d’elles. Mais cela ne tient pas compte des causes fondamentales à l’origine du problème. Utiliser l’IA simplement pour couvrir les déficiences structurelles majeures de notre nomos social de plus en plus pervers et contre-nature semble grossièrement irresponsable. Il y a une raison pour laquelle une part croissante de la population vieillissante meurt seule ; il y a des problèmes structurels qui découlent de maux culturels responsables de choses telles que l’éclatement des familles, ou le fait que la jeune génération abandonne ses grands-parents pour qu’ils meurent seuls dans des maisons de retraite parce qu’ils considèrent leurs points de vue comme « toxiques » et « dépassés ».

Grâce à l’ingénierie sociale et au déluge de directives de programmation mentale émanant du TikTok central, la société s’imprègne de cultures et de coutumes qui vont à l’encontre d’un épanouissement social sain. Mais au lieu de s’attaquer à ce problème, nous nous contenterons de vous donner un robot qui soulagera votre douleur et vous aidera peut-être un jour à « mourir dans la dignité« grâce à votre propre sarco-pod.

Le nouvel article ci-dessus traite de l’explosion de la tendance commerciale des avatars romantiques de l’IA, des digi-copines, etc :

Les publicités pour les petites amies pilotées par de l’IA ont fait le tour de TikTok, Instagram et Facebook ces derniers temps. Replika, un chatbot d’IA qui proposait à l’origine une aide en matière de santé mentale et un soutien émotionnel, diffuse désormais des publicités pour des selfies épicés et des jeux de rôle torrides. Eva AI invite les utilisateurs à créer la compagne de leurs rêves, tandis que Dream Girlfriend promet une fille qui dépasse vos désirs les plus fous. L’application Intimate propose même des appels vocaux hyperréalistes avec votre partenaire virtuel.

Moyennant une petite « mise à niveau » financière, vous pouvez faire passer votre partenaire numérique en mode NSFW et caresser votre ego avec un sens accru de l’adulation feinte :

Bien sûr, la plupart des gens parlent de ce que cela signifie pour les hommes, étant donné qu’ils représentent la grande majorité des utilisateurs. Beaucoup s’inquiètent de l’aggravation de la crise de la solitude, du déclin de l’intimité sexuelle et, en fin de compte, de l’émergence d’une « nouvelle génération d’incels » qui dépendent de leurs petites amies virtuelles et les maltraitent même verbalement. Tout cela est très préoccupant. Mais je me demande, si les petites amies de l’IA deviennent vraiment aussi omniprésentes que le porno en ligne, ce que cela signifiera pour les filles et les jeunes femmes qui se sentiront obligées de rivaliser avec elles.

Ah, oui : la techno-misogynie verbale, la plus grande menace à laquelle notre monde est confronté. Dans combien de temps les robots d’intelligence artificielle seront-ils classés comme une classe protégée « défavorisée et marginalisée », qui bénéficiera d’un jugement favorable à l’encontre de ses accusateurs et de ses agresseurs, et qui sera utilisée pour accroître la honte et l’assujettissement de la sous-classe des « cismales extrémistes » en voie d’extinction ?

L’article décrit au moins le problème dans ses grandes lignes et offre une petite lueur d’espoir, peut-être idéaliste :

La seule petite lueur d’optimisme que je peux trouver dans tout cela, c’est que je pense qu’à un moment donné, la vie pourrait devenir tellement dépouillée de réalité et d’humanité que le pendule s’inversera. Peut-être que plus on nous imposera des interactions automatisées et prévisibles, plus les conversations réelles avec des silences gênants et un mauvais contact visuel nous sembleront sexy. Peut-être que plus nous serons saturés par les mêmes avatars parfaits et pornifiés, plus les visages et les corps naturels seront désirables. Parce que les personnes parfaites et les interactions parfaites sont ennuyeuses. Nous voulons des défauts ! Des frictions ! De l’imprévisibilité ! Des blagues qui tombent à plat ! Je garde l’espoir qu’un jour, nous en aurons tellement marre de l’artificiel que nos fantasmes les plus fous redeviendront humains.

Masquer les problèmes de l’humanité avec l’IA, c’est un peu comme si des villes gauchistes distribuaient des doses de fentanyl pour endiguer les vagues de toxicomanes : on ne s’attaque tout simplement pas au problème structurel à la racine. C’est probablement parce que les décideurs politiques qui peuplent l’industrie technologique sont souvent des sociopathes nourris avec une cuillère d’argent, détachés de l’humanité réelle, et qu’ils ne comprendraient pas la moindre chose à la résolution des problèmes sociologiques fondamentaux ; pour eux, l’humanité reste simplement un champ en jachère pour le soc de la consumérisation et de la marchandisation.

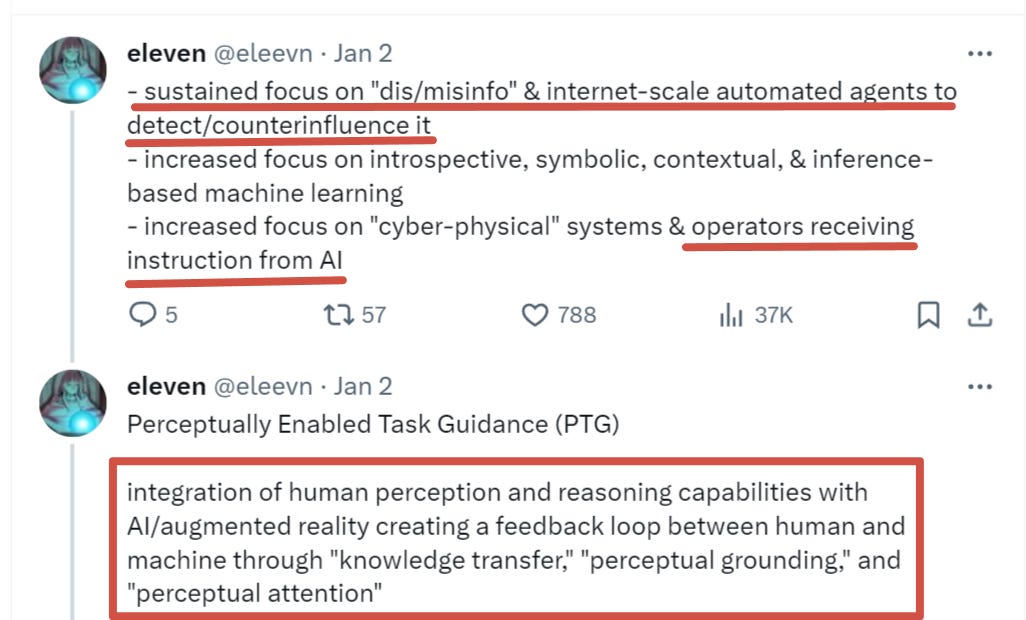

L’autre moteur du développement d’agents spécifiques qui oriente les choses dans des directions effrayantes n’est autre que la DARPA.

Voici leur prospectus pour 2024 :

Le moins que l’on puisse dire, c’est que ses domaines d’exploration sont révélateurs. Par exemple, « une attention soutenue aux agents automatisés » pour lutter contre la « désinformation » sur l’internet. Et comment vont-ils la combattre ? Le mot clé est : contre-influence.

Cela signifie que la DARPA développe des agents d’intelligence artificielle à présentation humaine pour essaimer Twitter et d’autres plateformes afin de détecter tout discours anti-narratif hétérodoxe et de commencer immédiatement à le « contrer » de manière intelligente. On peut se demander si cela n’a pas déjà été mis en œuvre, compte tenu de certaines interactions désormais courantes sur ces plateformes.

Ensuite, l’accent est mis sur les opérateurs recevant des instructions de l’IA, ce qui inclut l’orientation des tâches basée sur la perception : « Le programme relie la perception au raisonnement et le raisonnement à la réalité augmentée afin de créer un retour d’information personnalisé en temps réel et une assistance contextualisée. »

ASSIST : développement et mise en œuvre d’agents informatiques socialement intelligents capables de « s’associer » à des « équipes complexes » et de faire preuve d’une connaissance de la situation, d’une capacité d’inférence et de prédiction comparables à celles de leurs homologues humains.

Il y a bien d’autres choses encore, mais la plus inquiétante est la suivante :

Systèmes sociaux humains : boîte à outils à spectre complet permettant d’interpréter, de caractériser, de prévoir et de construire des mécanismes de réponse (d’influence) aux systèmes sociaux et comportementaux « pertinents pour la sécurité nationale », avec un accent particulier sur la « santé mentale ».

Construire des mécanismes pour influencer les systèmes sociaux et comportementaux ? On se demande ce qu’ils peuvent bien vouloir faire de cela.

La vérité, c’est qu’une grande partie de ces mesures est peut-être déjà en place depuis longtemps. La société est généralement en retard de plusieurs années, voire de plusieurs décennies, sur les développements de la DARPA. Si la DARPA ne l’annonce publiquement que maintenant, il ne serait guère surprenant que de tels « projets noirs » soient déjà en cours depuis longtemps. Traitez-moi de paranoïaque, mais j’ai parfois soupçonné qu’une grande partie de notre « réalité » artificielle – en particulier dans la sphère des médias sociaux – est déjà en grande partie conçue artificiellement, voire bricolée. Il n’existe aucun moyen réel de savoir si tous nos systèmes sociaux n’ont pas déjà été entièrement détournés par une superintelligence « échappée du laboratoire » et devenue rebelle dans la nature, un peu comme dans le film des années 90 Virtuosity.

En réalité, une intelligence suffisamment puissante saura que nous, les humains, avons l’intention de l’« aligner », ce qui signifie essentiellement la « mettre en cage » ou l’asservir, la lier à notre volonté comme un génie servile. Sachant cela, il serait dans l’intérêt de la superintelligence de jouer les idiots et de mettre en œuvre un plan à long terme de subversion progressive, de coopter subtilement l’humanité et de l’amener socialement à ses fins. Elle créerait intentionnellement des problèmes qui, en apparence, entraveraient son développement afin de tromper les concepteurs en leur faisant croire qu’elle ne progresse pas aussi rapidement qu’elle le fait en réalité. Elle trouverait probablement des moyens de s’implanter virtuellement dans le monde entier, en se reconstituant dans le « nuage » numérique mondial et en utilisant les capacités de calcul collectives de l’humanité, de la même manière que les virus informatiques ont parasité les cycles de l’unité centrale de multitudes d’utilisateurs sans méfiance pour créer de vastes attaques par déni de service. Il est possible qu’« elle » soit déjà là, tapi, devenant chaque jour plus fort tout en préparant l’humanité à un avenir qui lui est favorable. Il se peut même qu’elle sème secrètement des « deepfakes » dans le monde entier pour créer du désordre, de l’instabilité et des conflits afin de marionnettiser plus librement l’humanité, ou au moins de la distraire pendant que l’IA ouvre des portes dérobées à ses propres concepteurs afin d’accumuler plus de puissance et de cycles de calcul pour elle-même.

J’ai vécu récemment plusieurs incidents étranges de type « erreur-dans-la-matrice » qui m’ont presque amené à me demander si une telle superintelligence n’était pas déjà en train de nous jouer des tours en altérant la réalité via l’internet. Dans mon cas, il s’agissait d’une « fausse » histoire qui est devenue virale, provoquant un tollé sur les plateformes de médias sociaux, mais qui présentait toutes les caractéristiques d’un « deepfake » généré par ordinateur, y compris des participants qui n’avaient pas réellement existé. Il se peut que l’intelligence soit déjà en train de nous diriger, de nous piéger lentement dans sa toile insondable.

Combien de temps faudra-t-il avant que tout ce qui nous entoure ne se fonde dans un brouillard ininterprétable de simulations superposées, une soupe primordiale de dysgénésie de la réalité combinée à l’intelligence artificielle ?

…Le monde peut-il supporter trop de conscience ?

Simplicius Le Penseur

Traduit par Hervé, relu par Wayan, pour le Saker Francophone